随着移动设备的性能不断提升,我们现在可以在Android手机上部署和运行大型机器学习模型了。这为开发者和技术爱好者提供了前所未有的便利性和可访问性。在这篇文章中,我们将探讨如何使用Termux和ollama在Android手机上部署离线大模型。

Termux(Termux基础安装配置)是一个Android平台上的终端模拟器,它提供了Linux环境,无需root权限即可运行。通过Termux,用户可以安装各种Linux软件包,实现在手机上进行编程和服务器管理等操作。而ollama(github地址)则是一个基于Go语言开发的本地大模型运行框架,它允许用户在本地设备上运行和管理机器学习模型。

通过Termux和ollama可以在手机上运行如LLAMA3-8b或LLAMA2-7b这样的大型模型,进行机器学习和人工智能的实验和开发。

值得注意的是,部署大模型需要考虑手机的性能和存储空间。大型模型通常需要较多的计算资源和存储空间,因此在配置较低的手机上运行可能会遇到性能瓶颈。此外,模型的下载和安装过程可能需要较长的时间和稳定的网络连接。

安装相关依赖

pkg upgrade

pkg install git cmake golang -y编译ollama

git clone --depth 1 https://github.com/ollama/ollama.git

cd ollama

go generate ./...

go build .将ollama添加到环境变量

cp ollama/ollama /data/data/com.termux/files/usr/bin/启动ollama服务和离线大模型

可用模型参考:ollama.com/library

运行7B参数大模型需要8G RAM,13B参数大模型需要 16GB RAM,再大规模的没有必要在手机上尝试了

ollama serve &

ollama run qwen2:1.5b执行完ollama serve &后,如果无法输入新命令,需要按一下回车。

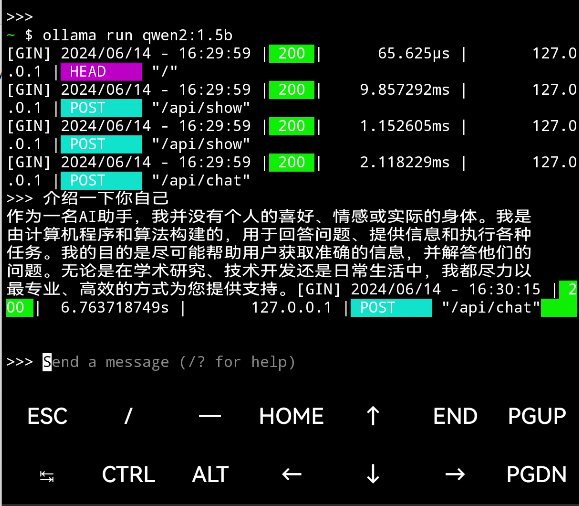

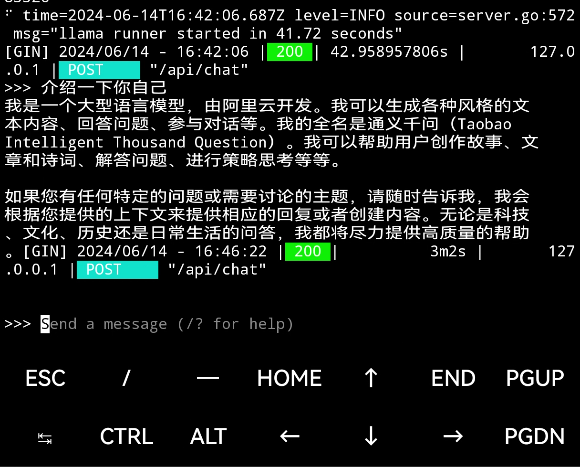

运行效果

1.5b的Qwen2:

7b的Qwen2:

最后一次更新于October 22nd, 2024